Setup Game

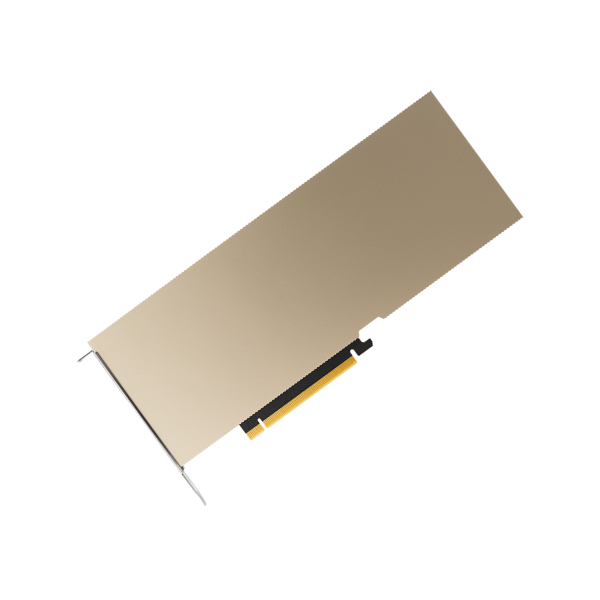

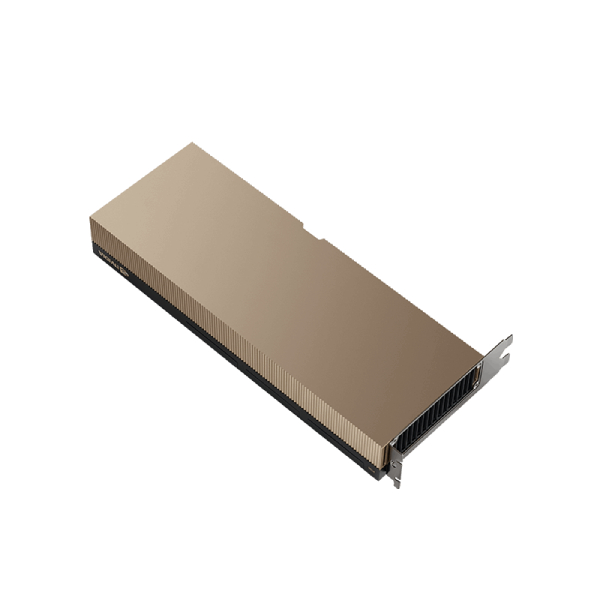

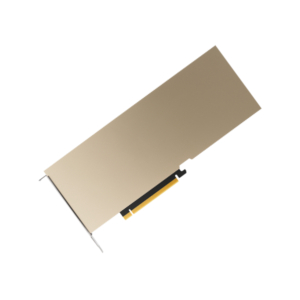

PNY NVIDIA H100 NVL PCIE 94Go HBM3

H100 NVL est conçu pour étendre la prise en charge des modèles de langages étendus (MLL) dans les systèmes serveurs PCIe grand public. Grâce à des performances brutes accrues, une mémoire HBM3 plus importante et plus rapide, et une connectivité NVLink via des ponts, les systèmes grand public configurés avec 8 NVL H100 surpassent jusqu’à 12 fois les systèmes HGX A100 avec un débit LLM GPT3-175B.

Rupture de stock

Product Description

GPU SERVER PNY NVIDIA H100 NVL PCIE 94Go Maroc

Performances, évolutivité et sécurité inégalées pour tous les centres de données

H100 NVL est conçu pour étendre la prise en charge des modèles de langages étendus (MLL) dans les systèmes serveurs PCIe grand public. Grâce à des performances brutes accrues, une mémoire HBM3 plus importante et plus rapide, et une connectivité NVLink via des ponts, les systèmes grand public configurés avec 8 NVL H100 surpassent jusqu’à 12 fois les systèmes HGX A100 avec un débit LLM GPT3-175B.

H100 NVL permet aux serveurs grand public standard de fournir une inférence IA générative hautes performances pour les MLL, tout en offrant aux partenaires et aux fournisseurs de solutions une mise sur le marché plus rapide et une évolutivité aisée.

FP64 | 30 TFLOPS |

|---|---|

FP64 Tensor Core | 60 TFLOPS |

FP32 | 60 TFLOPS |

TF32 Tensor Core | 835 TFLOPS | Sparsity |

BFLOAT16 Tensor Core | 1671 TFLOPS | Sparsity |

FP16 Tensor Core | 1671 TFLOPS | Sparsity |

FP8 Tensor Core | 3341 TFLOPS | Sparsity |

INT8 Tensor Core | 3341 TOPS | Sparsity |

GPU Memory | 94GB HBM3 |

GPU Memory Bandwidth | 3.9 TB/s |

Max Thermal Design Power (TDP) | 350-400W (Configurable) |

NVIDIA AI Enterprise | Included |

Product Reviews

Produits Similaires

Les produits les plus proches de ceux que vous voyez actuellement.

Avis

Il n’y a pas encore d’avis.